Wyniki ankiety: Konfrontacja mitów SEO

Raporty4 lipca 2013

Postanowiliśmy sprawdzić, ile jest prawdy w powszechnie krążących mitach SEO. Zapytaliśmy o nie 188 osób z branży, część z nich porównując z oficjalnymi zapewnieniami ze strony Google. Poniżej znajduje się 10 mitów i zdania ankietowanych na ich temat.

Lista mitów:

- Mit 1: Google manipuluje pozycjami serwisów konkurencyjnych, aby wypromować swoje produkty

- Mit 2: Można zaszkodzić pozycjom konkurencyjnej strony linkami

- Mit 3: Strony bez wersji mobilnych będą miały gorsze pozycje niż te z nimi

- Mit 4: Dla Google najważniejszy jest użytkownik i pod tym kątem wyszukiwarka dba o swoje wyniki

- Mit 5: Narzędzie disavow links tool szkodzi zgłaszanym stronom

- Mit 6: PR strony się zmniejsza, jeśli zamieszcza się na niej dużo linków wychodzących

- Mit 7: Linki site-wide szkodzą i należy ich unikać za wszelką cenę

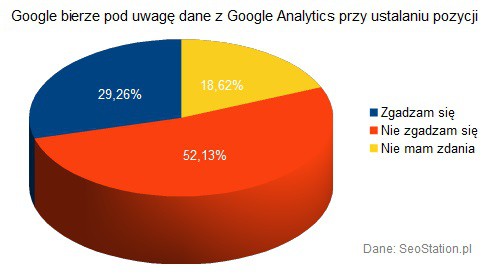

- Mit 8: Google bierze pod uwagę dane z Google Analytics przy ustalaniu pozycji

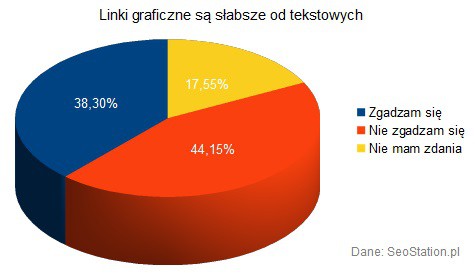

- Mit 9: Linki graficzne są słabsze od tekstowych

- Mit 10: Google dobrze radzi sobie z rozpoznaniem duplikatów i wyświetlaniem na wyższej pozycji strony z oryginalnym artykułem

Mit 1: Google manipuluje pozycjami serwisów konkurencyjnych, aby wypromować swoje produkty

Wielokrotnie webmasterzy zarzucali Google, że manipuluje pozycjami serwisów konkurencyjnych, aby zrobić miejsce własnym produktom. Nawet w zeszłym roku, kiedy Google postanowiło nałożyć ręczne filtry na kilka popularnych porównywarek cenowych i innych serwisów e-commerce'owych, uważano, że wyszukiwarka przygotowuje się do wprowadzenia na polski rynek usługi - Zakupy Google (Google Shopping).

Ponad połowa ankietowanych potwierdza to stanowisko (55,23%), jednak sporo osób (27,13%) wstrzymało się od odpowiedzi na to pytanie, więc ciężko jednoznacznie stwierdzić, czy mit udało się potwierdzić. Tym samym uznajemy go za...

Mit 2: Można zaszkodzić pozycjom konkurencyjnej strony linkami

Kiedy jeszcze Google utrzymywało, że bardzo trudno jest zaszkodzić konkurencyjnej stronie, nie było tak dużego zdecydowania w temacie możliwości depozycjonowania.

„(...) można by pomyśleć, że skoro SWLe przekazujące PageRank wychodzą poza zasady Google, to wykupując na przykład rotacyjne linki i zgłaszając raport spamu można zaszkodzić konkurencji. Ponieważ jednak bierzemy większą ilość sygnałów pod uwagę, takie działanie na niekorzyść innych webmasterów jest skuteczne wyłącznie w teorii.”

Źródło: http://googlepolska.blogspot.com/2008/11/jak-google-postrzega-linkowanie.html (17 listopada 2008; Kaspar Szymański)

Jednak od wprowadzenia aktualizacji o nazwie Pingwin w kwietniu zeszłego roku, której data pokrywała się z masową wysyłką powiadomień o wykryciu nienaturalnych linków przychodzących, większość ma zdecydowane stanowisko w tej sprawie.

Uważa się, że skoro można doprowadzić do nałożenia filtra na własną stronę, to samo można zrobić z serwisem konkurencyjnym, z czym zgadza się znaczna większość ankietowanych (84,57%). Działanie takie jest jednak tym trudniejsze, im silniejsza i bardziej zaufana jest strona, a najłatwiejsze jest przy serwisach stronach, w szczególności z podejrzanym profilem linków.

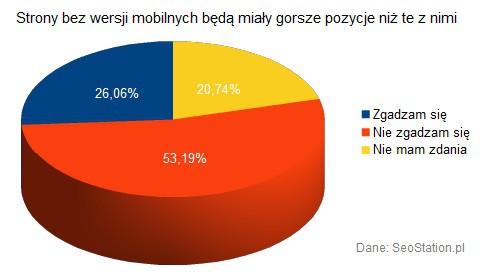

Mit 3: Strony bez wersji mobilnych będą miały gorsze pozycje niż te z nimi

W pierwszej połowie czerwca br. zostaliśmy zasypani informacjami z różnych źródeł na temat rzekomego pogorszenia pozycji w Google dla stron, które mają słabe wersje mobilne, albo nie mają ich w ogóle. Chodziło m.in. o sytuacje, w których przy wyszukiwaniu mobilnym, użytkownik zamiast trafić na podstronę z konkretnym artykułem, jest przekierowywany na stronę główną. Problem w tym, że wiele osób błędnie zinterpretowało tę informację. Podczas gdy zgodnie z zapowiedziami Google, zmiana miała dotknąć wyłącznie wyników wyszukiwania dla urządzeń mobilnych:

„To improve the search experience for smartphone users and address their pain points, we plan to roll out several ranking changes in the near future that address sites that are misconfigured for smartphone users.”

Źródło: http://googlewebmastercentral.blogspot.com/2013/06/changes-in-rankings-of-smartphone_11.html (11 czerwca 2013; Yoshikiyo Kato)

na polskich serwisach pisano, że:

„Google oficjalnie ogłosił, że będzie karał serwisy internetowe, które nieprawidłowo wyświetlają się na telefonach komórkowych i tabletach”

„Kara nałożona przez wyszukiwarkę może dotknąć blisko 70% stron internetowych w Polsce, które nie mają witryn mobilnych - spadną one znacznie w wynikach wyszukiwania (...)”

Źródło: http://online-marketer.com.pl/2013/9284.html

„Google poinformowało na swoich stronach, że będzie obniżało w wynikach wyszukiwania pozycję stron, które po macoszemu traktują mobilnych użytkowników.”

Źródło: http://di.com.pl/news/48330,0,Google_ukarze_witryny_ktore_maja_slabe_wersje_mobilne_Lepiej_pozno_niz_wcale-Adrian_Nowak.html (13 czerwca 2013; Adrian Nowak)

w których to nie ma jasnego przekazu mówiącego, że zmiany dotyczą wyłącznie wyników dla urządzeń mobilnych i że w oryginalnym materiale nie ma wzmianki o ewentualnych karach, a jedynie o dostosowaniu algorytmu pod użytkowników mobilnych. A co na ten temat sądzą ankietowani?

Ponad połowa osób (53,19%) biorących udział w ankiecie nie zgodziła się ze stwierdzeniem, jakoby strony bez wersji mobilnych miały mieć gorsze pozycje niż te, które takie wersje posiadają. Tylko 1/4 (26,06%) sprzeciwiła się temu, jednak biorąc pod uwagę większość głosów i mając do porównania oryginalny wpis na blogu Google z błędnym tłumaczeniem na polskich stronach, możemy ten mit uznać za:

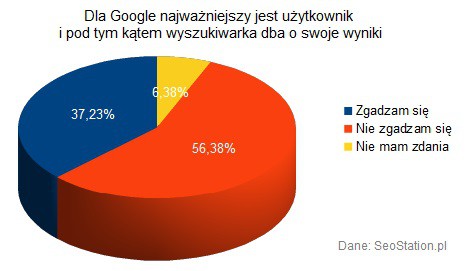

Mit 4: Dla Google najważniejszy jest użytkownik i pod tym kątem wyszukiwarka dba o swoje wyniki

Pierwsza z „dziesięciu prawd Google” głosi, że:

„Od samego początku koncentrujemy się na dostarczaniu użytkownikom najlepszych możliwych rozwiązań. Niezależnie od tego, czy projektujemy nową przeglądarkę internetową, czy dopracowujemy wygląd strony głównej, bardzo dbamy o to, aby nasze usługi służyły przede wszystkim użytkownikowi, a nie naszym wewnętrznym celom lub wynikom finansowym.”

Źródło: http://www.google.com/about/company/philosophy/

Jednak większość ankietowanych (56,38%) twierdzi, że to właśnie wyniki finansowe są najważniejsze, zarówno dla Google, jak i każdej innej firmy.

Mimo wszystko aż 37,23% opowiedziało się po przeciwnej stronie, dlatego ostateczny rezultat to:

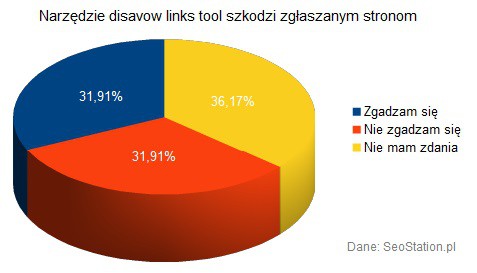

Mit 5: Narzędzie disavow links tool szkodzi zgłaszanym stronom

Narzędzie disavow links tool powstało po to, aby webmasterzy mieli większy wpływ na to, które z linków kierujących do ich stron powinny być brane pod uwagę przy ustalaniu rankingu, a które nie. Miało ono pomóc w pozbyciu się kar Google nałożonych z powodu wykrycia nienaturalnych linków przychodzących. Sam John Mueller podczas jednego z hangoutów na Google+ zapewniał, że obecnie to jedyny cel, do jakiego to narzędzie służy i że często zgłaszane strony nie są dodatkowo analizowane.

Jednak w rozmowach webmasterów pojawiają się wręcz skrajne opinie na ten temat. Jedni są pewni, że narzędzie służy wyłącznie do pomocy stronom, na które nałożono filtr. Inni określają to mianem podcinania gałęzi, na której się siedzi. Zdaniem tych drugich, byłoby dziwne, gdyby Google nie wykorzystywało tak ogromnej ilości zebranych w ostatnim roku danych – czy to do nauczania algorytmu, jak lepiej wykrywać nienaturalne linki, czy to do masowego zerowania wartości często zgłaszanych serwisów, a nawet ich banowania, czy chociażby do automatycznego flagowania stron do późniejszego ręcznego sprawdzenia. Mimo wszystko zdania na ten temat były podzielone i aż 1/3 osób (36,17%) nie była w stanie odpowiedzieć na to pytanie.

Mit uznajemy za:

Mit 6: PR strony się zmniejsza, jeśli zamieszcza się na niej dużo linków wychodzących

Od wielu lat na forach i blogach można znaleźć wypowiedzi na temat tego, że nie warto zamieszczać na swojej stronie zbyt wielu linków, bo przechodzi na nie część PR i tym samym stronie zostaje go coraz mniej. Jakie obecnie jest zdanie na ten temat?

Zdania na ten temat są podzielone. Jednak większość tych, która zgadzała się z tą teorią podkreśla, że dotyczy to wyłącznie sytuacji, w których dochodzi do nałożenia kary przez Google w wyniku wykrycia dużej liczby linków wychodzących, przez co stronę podejrzewa się o handel linkami. Osoby te zaznaczają jednak, że dopóki zachowuje się umiar, a linki kierują do dobrych jakościowo serwisów, PR strony zamieszczającej link nie zmniejsza się.

Ze względu na spore różnice zdań, mit uznajemy za:

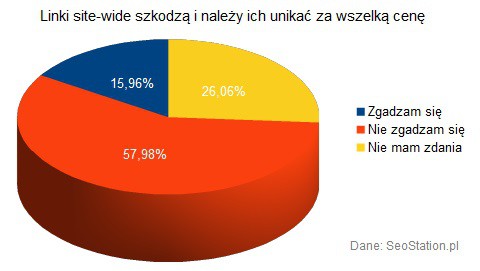

Mit 7: Linki site-wide szkodzą i należy ich unikać za wszelką cenę

Coraz częściej, m.in. w wyniku wypowiedzi pracowników Google, webmasterzy obawiają się zamieszczania, a także zdobywania linków site-wide (wyświetlanych na wszystkich podstronach serwisu) w obawie przed uznaniem ich za nienaturalne. Nawet w poradach Johna Muellera odnośnie przygotowywania pliku z niechcianymi linkami, należy zwrócić szczególną uwagę na tego typu linki i stosować komendę domain:adresstrony.pl zamiast listować kilka pojedynczych adresów podstron w zgłoszeniu. Czy jednak na pewno takie linki są szkodliwe?

Ponad połowa ankietowanych (57,98%) nie zgadza się z tym i uznaje linki site-wide za jak najbardziej naturalne. Jednak większość z nich zwraca uwagę na to, że bezpieczniej jest linkować w taki sposób anchory brandowe, a nie komercyjne (tj. ze słowami kluczowymi) i zachować tematyczność linkowania. Podkreślają również, że linki site-wide są dobrym sposobem na zróżnicowanie profilu backlinków pod warunkiem, że zachowuje się w nich umiar.

Mit został uznany za:

Mit 8: Google bierze pod uwagę dane z Google Analytics przy ustalaniu pozycji

Od dość dawna można się spotkać z opiniami na temat tego, że Google przy ustalaniu rankingu bierze pod uwagę dane statystyczne takie jak liczba odwiedzin, wskaźnik odrzuceń, czy też liczbę odwiedzonych podstron. Z drugiej strony, z Google Analytics korzysta tylko część stron, a aby ruch na stronie mógł mieć wpływ na jej pozycję, dane na jego temat powinny być dostępne dla wszystkich stron.

Zapytaliśmy 188 osób o to, co sądzą na ten temat.

Większość (52,13%) nie zgodziła się z tym, że dane z GA mogą w jakikolwiek sposób wpływać na pozycję strony. Matt Cutts również temu zaprzecza, mówiąc:

„Not only do we not use it in Web Spam. I promise you my web team will never go and ask the analytics team to use their data.”

„Google Analytics is not used in search quality in any way for our rankings.”

Źródło: http://www.youtube.com/watch?v=CgBw9tbAQhU (2 luty 2010; Matt Cutts)

Jedną z ciekawych sugestii wśród komentarzy do ankiety było zdanie na temat tego, że Google może przecież brać pod uwagę klikalność wyników, która jest dostępna dla wszystkich zaindeksowanych stron.

Na tę chwilę uznajemy ten mit za:

Mit 9: Linki graficzne są słabsze od tekstowych

Wiele osób ma wątpliwości co do tego, czy warto używać linków graficznych w pozycjonowaniu do innych celów, niż tylko jako forma zróżnicowania profilu backlinków. Inni twierdzą, że skoro w atrybucie ALT dla obrazka można zawrzeć dowolne słowa kluczowe, to jest on traktowany na równi z anchorem linka tekstowego. Kolejni powołują się na wyniki testów, według których Google nadaje wyższy priorytet linkom tekstowym – mając do wyboru 2 linki, z czego pierwszy jest graficzny (z uzupełnionym atrybutem ALT), a drugi tekstowy, Google pominie pierwszy i weźmie pod uwagę anchor linka tekstowego.

Z pewnością jest to kwestia do przetestowania, jednak ze względu na małą przewagę głosów na „nie”, mit uznajemy za:

Mit 10: Google dobrze radzi sobie z rozpoznaniem duplikatów i wyświetlaniem na wyższej pozycji strony z oryginalnym artykułem

Na koniec zostawiliśmy sobie temat powielania treści i tego, jak radzi z tym sobie wyszukiwarka. Zapewne każdemu z nas zdarzało się widzieć na wyższych pozycjach w Google artykuł skopiowany, niż ten oryginalny. Samo Google niewiele pisze na temat sposobów wykrywania duplikatów, mimo zapewnień o tym, że mechanizm ten radzi sobie coraz lepiej. Z oficjalnych wypowiedzi wiemy jedynie, że podstrona z wyższym PR (jako bardziej popularna) ma większe szanse na to, aby uznać ją za źródło informacji.

„(...) if you do syndicate content, make sure that you include a link to the original content. That will help ensure that the original content has more PageRank, which will aid in picking the best documents in our index.”

Źródło: http://www.mattcutts.com/blog/duplicate-content-question/ (1 luty 2008; Matt Cutts)

Ankietowanym również nie było łatwo udzielić jednoznacznej odpowiedzi na pytanie o to, czy Google dobrze sobie radzi z rozpoznaniem duplikatów.

Pojawiały się jednak sugestie odnośnie tego, że strona bardziej zaufana będzie miała większe szanse na uznanie jej za oryginał, stąd też obawa webmasterów o pozycje ich artykułów w przypadku ich przedruku na popularnych serwisach.

Ostatni mit uznajemy zatem za:

i pozostaje nam zachęcić Was do przeprowadzenia własnych testów zarówno w tym temacie, jak i poruszonych w poprzednich mitach.

Administracja SeoStation

Administracja SeoStation

Stare komentarze: 10

Po wczorajszym i dzisiejszym dniu chyba trzeba powtórzyć ankietę, zwłaszcza jeśli chodzi o Mit 5 :)

Od 1,5 tygodnia jest wprowadzany update, stąd te zmiany ;-)

Na prośbę dopisuję skrót najciekawszych wypowiedzi:

- gdyby faktycznie Google manipulowało pozycjami serwisów konkurencyjnych i wyszłoby to na jaw, byłby z tego niezły skandal;

- przykładem na manipulowanie wynikami było wprowadzenie widgetu wyświetlanego w Google dla zapytania "psy rasowe";

- można zaszkodzić konkurencyjnej stronie, jeśli ma słaby TR i podejrzany profil linków, i skieruje się na nią tysiące linków słabej jakości, w szczególności słabo albo w ogóle nie różnicując anchorów;

- narzędzie disavow links tool służy do poprawy algorytmu;

- jeśli wiele osób zgłasza w narzędziu disavow links tool te same domeny, są one flagowane do późniejszego przejrzenia;

- link graficzny może być nawet mocniejszy, niż tekstowy, ale trzeba go opatrzyć odpowiednim altem;

- aby artykuł został oznaczony jako oryginał, dobrze jest zastosować w Google+ oznaczenie, że jest się jego autorem;

- jeśli kilka serwisów opublikuje ten sam tekst, może pojawić się problem, jeśli jest on udostępniany także na FaceBooku.

Pamiętajcie, że to nie zawsze opinie większości, a jedynie te najciekawsze spośród wszystkich nadesłanych.

Taka ankieta powinna zawierać jeszcze wykres paranoi polskich SEO'wców, którzy uważają, że Google za wszelką cenę chce uwalić ich strony. Sporo "mitów" jest niepotwierdzonych, więc nic to raczej nie zmienia, bo nikt nie może być pewny tego czy dany czynnik ma taki czy inny wpływ na pozycje.

"gdyby faktycznie Google manipulowało pozycjami serwisów konkurencyjnych i wyszłoby to na jaw, byłby z tego niezły skandal" - och, w Google byliby załamani! ;) W końcu nigdy jeszcze nie bylo afery o naruszenia prywatnosci i wszystkie duże korporacje typu Google, Microsoft, Yahoo, Motorola itp. słyną z tego, ze są nieskalani ;)

Gdyby Google manipulowało wynikami to na pewno Komisja Europejska by coś powiedział. Chociaż po PRISM pewnie nikogo nic już nie zdziwi.

Bardzo podoba mi się formuła ankiety i pytań. Natomiast uważam, że stawianie tez na jej podstawie, to grube nadużycie. To że sto, czy ileś osób coś twierdzi, wcale nie oznacza, że tak jest! Nie mniej jednak tak jak pisałem pomysł i formuła bardzo ciekawa

"stawianie tez na jej podstawie, to grube nadużycie"

Zasady obalania mitów są jasne, więc myślę, że każdy sam może ocenić, na ile pod tym względem może ufać większości ankietowanych. Pytanie - czego w takim razie potrzeba do obalenia czy potwierdzenia danego stwierdzenia? Oficjalnych stanowisk Google ;-) czy wyników testów wykonanych przez 1-2 osoby, do których mógł się wkraść błąd, albo ich wyniki mogą być inne od testów kolejnej osoby.

Przykładowo, jeden z bloggerów stwierdził, że ruch na stronie ma znaczenie pod kątem rankingowym i że wystarczą 3 dni mocno zwiększonego ruchu, aby odbiło się to na pozycjach. Z kolei moje testy w podobnym okresie pokazały, że to nie ma najmniejszego znaczenia.

Chodzi mi o to, że bardzo ciężko jest przygotować takie wyniki, aby była dosłownie 100% pewność co do ostatecznego wyniku.

Google to nie jedna osoba tylko cała korporacja, wielu pracowników i cała struktura stanowisk a wielu seo-wców ma tendencje do personifikacji wielkiego google-a.

Jeśli miała by nastąpić ręczna manipulacja wynikami to nie na niższym szczeblu (bo przeciętnego pracownika raczej nie obchodzi na jakiej pozycji jest jedna z usług firmy w której pracuje).

Jeśli na wyższym szczeblu zapadłaby decyzja o manipulowaniu wynikami, musieliby przekazać te wytyczne niżej i zapoznać z nią całą grupę ludzi odpowiedzialną za dany temat. W takim przypadku ryzyko wycieku byłoby bardzo duże i szansa kompromitacji raczej nie warta zabiegów. Myślę że do możliwości takich ingerencji trzeba podchodzić zdroworozsądkowo bo realizacja takiego zadania byłaby trudna do przeprowadzenia.