Kontrowersje branży SEO, czyli na dwoje babka wróżyła

Artykuły3 sierpnia 2021

Wyobraź sobie czarną skrzynkę podającą ludziom dane, których akurat potrzebują. Z drugiej strony skrzynki wrzuca się mnóstwo różnych informacji. Ona zbiera je, przetwarza i wypluwa wybrane dane w konfiguracjach ustalonych według sobie tylko znanych zasad. Brzmi znajomo?

Google jest taką czarną skrzynką, a seowcy usiłują zrozumieć jej działanie, z lepszym lub gorszym skutkiem. Ten artykuł omawia kilka kontrowersyjnych poglądów, które warto zgłębić indywidualnie, zanim zastosujesz się do nich w swoich działaniach SEO.

1. Tata, bo Google powiedział...

W wielu dyskusjach dotyczących pozycjonowania przytaczane są wypowiedzi pracowników Google, które chciałoby się traktować jak wyrocznie. Tylko czy warto? Oficjalny podręcznik Google Webmaster Guidelines dostarcza sporo przydatnych informacji do tworzenia dobrego contentu, ale niewiele poza tym. Z kolei komunikaty, jakie kieruje wyszukiwarka do seowców i webmasterów przypominają trochę karmienie kota roślinną karmą - brakuje mięsa. Zdarzało się, że Google “gubiło się w zeznaniach” i choć stara się korygować tego rodzaju oświadczenia, takie sytuacje mimo wszystko zaburzają czytelność i transparentność.

Trudno zresztą spodziewać się konkretnej metodyki po mechanizmie, który stale się uczy i doskonali. W 2015 r. Google wprowadziło algorytm Rankbrain oparty na technologii sztucznej inteligencji, który odpowiada za dopasowanie wyników wyszukiwania do zapytań użytkowników. Stale usprawniany algorytm coraz lepiej rozumie ich intencje userów, korzystając z wielu danych o ich zachowaniach. Właśnie dlatego kładziony jest nacisk na tworzenie takich treści podstron, które będą odpowiadały na potrzeby użytkownika.

Warto mieć świadomość tego kierunku i w działaniach SEO pamiętać o tym najważniejszym celu obranym przez Google.

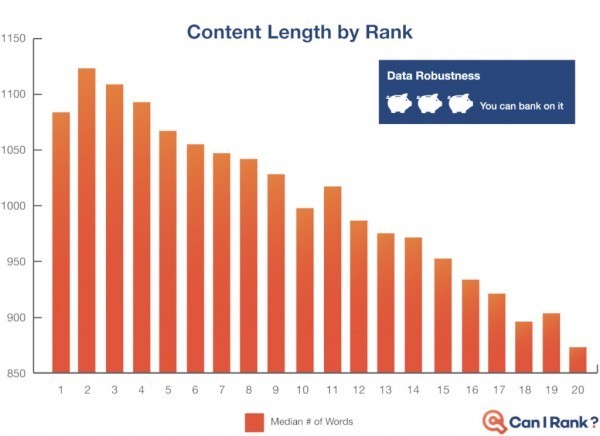

2. Długie treści są lepsze niż krótkie

Temat wałkowany i badany tak często, że w sieci można znaleźć gotowe widełki optymalnej długości dla opisów produktów, kategorii czy artykułów. Wciąż jednak podzielone są zdania co do szczegółów: czy lepiej lać wodę, czy napisać krócej i merytorycznie? Czy grafiki i multimedia w treści mają wpływ na pozycje? Czy przesada z długością tekstu może zaszkodzić?

Teoretycznie krótsza treść, która wyczerpuje zagadnienie, powinna być dla Google tak samo, jeśli nie bardziej atrakcyjna niż dłuższa z nic niewnoszącymi zdaniami podbijającymi liczbę znaków. Wystarczy jednak przejrzeć wyniki wyszukiwania dla popularnych słów kluczowych, by dostrzec, że w większości na pierwszych pozycjach znajdziemy te dłuższe treści, nawet jeśli są nieco sztucznie “pompowane”. Inna sprawa, że tak naprawdę wiele zależy od konkretnego zapytania i tego, co robi konkurencja.

Jak wskazuje Tomasz Biegun z WhitePress®: w kontekście wybranych wyników wyszukania tzn. słów kluczowych, najlepiej jest sprawdzić, co wyświetla się w top10 i starać się dać lepszą/dłużą treść od tego, co już zostało stworzone.

Długość treści a pozycje w wyszukiwaniach. Źródło: https://blog.canirank.com/wp-content/uploads/2017/01/contentlengthbyrank-1-1024x745.png

Z pewnością z roku na rok wyszukiwarka coraz lepiej czyta obrazki i wyróżniki tekstu, dlatego warto dbać o to, by treść była uzupełniana różnymi formami contentu. A co, jeśli copywritera poniosło i treść jest 2 razy dłuższa, niż w wytycznych? Nic. Jeśli tylko tekst jest poprawny i odpowiednio sformatowany, kolosalne rozmiary mogą tylko pomóc.

3. Linki wychodzące nie mają wpływu na pozycje

To grząski grunt i kolejne nierozstrzygnięte zagadnienie. Niektórzy jak ognia unikają linkowania innych stron (dofollow), są i tacy, którzy uważają, że link do zaufanej strony wpływa na wiarygodność tej, która linkuje. Istnieje również teza, że linki wychodzące nie obniżają mocy strony, ale duża ich liczba obniża moc każdego z nich. Z tego względu stosuje się wskaźnik określający stosunek liczby linków przychodzących do domeny do liczby linków wychodzących (taki wskaźnik dla portali podaje np. WhitePress®).

Zwolennicy linkowania na zewnątrz wzmiankują, że stwarza to też pewien potencjał do zdobycia backlinków (zwłaszcza przy dodatkowych działaniach content marketingowych). To jednak zalety poddawane w wątpliwość, zwłaszcza biorąc pod uwagę “koszt” takich działań - każdy aktywny link przekazuje jakąś część mocy strony.

Jeśli już postanawiamy stosować linkowanie do zewnętrznych treści, większość specjalistów będzie zalecać zachowanie kilku zasad:

- z umiarem (1-3 linków w artykule),

- z atrybutem target=”_blank” (otwiera link w nowej karcie),

- w sposób naturalny,

- do jakościowych domen.

4. Katalogi i fora - czy to ma sens?

Właściciele stron regularnie otrzymują oferty tanich pakietów z linkowaniem w katalogach, profilach i forach internetowych. Jak kończy się takie pozycjonowanie? Nie za dobrze, bo często bywa, że strona nie tylko nie wskakuje na wyższe pozycje, ale wręcz spada w SERP-ach. Czy to oznacza, że linkowanie z katalogów, forów i wizytówek online nie ma sensu?

Niekoniecznie, jeśli jest to robione dobrze i z umiarem. Według wielu głosów w branży ze względu na dywersyfikację źródeł linków takie działania mogą nawet pozytywnie wpłynąć na widoczność strony. Jednak jeśli już linkować w katalogach i forach, to - jak zalecają eksperci - możliwie naturalnie i raczej w jakościowych - mocnych, powiązanych tematycznie lub będących częścią większego portalu z historią, niż w zapleczówkach tworzonych tylko na potrzeby SEO.

5. Dobry content nie wystarczy

Google twierdzi, że wystarczy. Praktyka pokazuje, że to dziś tylko pobożne życzenie, Owszem, możesz stworzyć idealny, długi, atrakcyjny artykuł z bezkonkurencyjną zawartością merytoryczną, wygrać nim pozycje na kilka słów kluczowych i… na tym się skończy. Niestety era zdobywania w ten sposób naturalnych linków już się skończyła - świadomość SEO wzrosła i obecnie, kiedy już ktoś powołuje się na świetnie opracowaną treść, zwykle wskazuje źródło, ale bez podawania linku (ewentualnie nofollow).

A żeby content przyniósł faktyczny wzrost ruchu, widoczności, a nawet sprzedaży, potrzebuje linkowania i to z różnych, dobrych źródeł. Co więcej, nawet gdy o to zadbamy, jeśli strona nie jest zoptymalizowana pod wyszukiwarki, spektakularnych efektów nie będzie. Zatem pamiętając, że content is a king, miejmy z tyłu głowy, że linking is a queen, a mocno już rozwinięte królestwo Google wymaga, by nie zapominać też o kucharzach i paziach….

6. Cloaking to samo zło

Ta popularna kiedyś wśród zwolenników black hat SEO metoda była całkiem skuteczna, do czasu. Cloaking to ukrywanie przez robotami zawartości strony, która nie jest widoczna dla użytkownika. Z czasem, by poradzić sobie m.in. z tego rodzaju praktykami, Google opracowało coraz bardziej zaawansowane algorytmy, dzięki którym może wyłapać naruszające regulamin witryny i nałożyć na nie karę lub bana. Z tego względu stosowanie ukrytych tekstów czy zaszytych przekierowań powszechnie uważane jest dziś już nie tylko za nieuczciwe, ale i bezużyteczne, bo po prostu bardzo niebezpieczne dla strony.

To wszystko prawda, ale… obecnie w strukturach stron dość powszechne staje się wstawianie skryptów (głównie JS) pełniących określone funkcje, z treściami, których użytkownik strony nie widzi. Takie rozwiązania mogą więc z pozoru przypominać cloaking, ale są znacznie bezpieczniejsze - ich zastosowanie ma raczej ułatwiać robotom właściwe zczytywanie strony, niż manipulować wynikami wyszukiwania. Przykładem może być link sculpting – pilnowanie Page Rank witryny poprzez kontrolę przepływu mocy na podstrony (tagi nofollow czy sponsored).

Tak czy inaczej, są to rozwiązania dla doświadczonych w boju. Jeśli nie masz pewności, jak się w to bawić, lepiej nie podejmować zbędnego ryzyka.

7. Zombie, czyli meta keywords

Już 12 lat temu Google oficjalnie podało do informacji, że frazy w tagach meta keywords nie są brane pod uwagę jako czynnik rankinowy strony. Od tego czasu w uniwersum SEO przebywają w świecie umarlaków. Według niektórych specjalistów nadużywanie tych metatagów, zwłaszcza jeśli wpisane słowa są w nikłym stopniu powiązane z tematyką zawartości strony, może być nawet potraktowane jako spam i powodować spadki pozycji (choć trudno znaleźć przykład takich skutków).

Skoro jednak nie ma to znaczenia dla SEO, po co w strukturach stron nadal znajdujemy pole meta keywords? Pamiętajmy, że istnieją rozmaite narzędzia internetowe: katalogi informacyjne, mapy, czy agregaty, które pobierają dane m.in. z metatagów. Warto więc podejść do tego indywidualnie i zastanowić się, na ile przydatne mogą być te znaczniki dla danej witryny. Jeśli prowadzimy działania dla zagranicznych stron, trzeba też wziąć pod uwagę inne wyszukiwarki. Choć zarówno Yahoo, jak i Bing potwierdzają, że do meta keywords nie przywiązują wagi, w przypadku braku innych informacji o stronie mogą zostać uwzględnione. Z kolei Yandex wciąż uznaje meta keywords za ważny element rankingowy.

Elementy technicznego SEO istotne dla wyszukiwarki Yandex. Źródło: https://www.searchenginejournal.com/yandex-seo-guide/252885/#close

Ponadto, jak zauważają praktycy, w niektórych silnikach e-commersów można skorzystać z pola meta keywords do optymalizacji nagłówków H1, choć istnieją lepsze rozwiązania.

8. Prędko czy jeszcze prędzej - Page Speed

Obecnie szybkość ładowania się witryny, zwłaszcza w świetle wprowadzanych od czerwca jako czynnik rankingowy Core Web Vitals, jest jednym z najczęściej przewijających się tematów z zakresu technicznego SEO.

Nie wygląda na to, by optymalizacja PSI miała realny wpływ na pozycje, ale jej zaniedbanie może już skutkować spadkami - choć jak to będzie wyglądało w praktyce, dopiero mamy okazję poobserwować. Wdrożenie update’u związanego z Core Web Vitals ma być zakończone w sierpniu, więc na wszelki wypadek wielu seowców pilnie sprawdza i poprawia wyniki w Page Speed Insights. Logika podpowiada, jak zazwyczaj w SEO, indywidualne podejście.

Jeśli obserwujesz opóźnienia, które utrudniają korzystanie ze strony przeciętnemu użytkownikowi i przyczyniają się do licznych odrzuceń, a wyniki w PSI są alarmujące, oczywiście potrzebna jest gruntowna optymalizacja.

Jeśli jednak pod względem UX jest dobrze, a walka ze wskaźnikami rozbija się o kilka punktów w te czy we wte, wniosek nasuwa się sam. Ostatecznie to nie matura - zdobycie najwyższej liczby punktów w teście nie będzie miało wielkiego wpływu na przyszłość.

Podsumowanie

Nauka SEO opiera się przede wszystkim na doświadczeniu, bo inaczej się nie da. Google stosuje coraz bardziej zaawansowane algorytmy, usprawnia je i testuje. Przypomina to funkcjonowanie żywego organizmu, stąd w niektórych kwestiach nie sposób wyprowadzić jednoznacznych wniosków, które będą stale aktualne. Pozostaje robić swoje, dzielić się wiedzą i śledzić konsekwencje kolejnych kroków giganta z Mountain View.

Patrycja Kosek

Patrycja Kosek