Oficjalne wytyczne dotyczące crawl budget w przewodniku Google

Artykuły8 stycznia 2021

Na stronie Google Search Central opublikowano przewodnik po zarządzaniu budżetem indeksowania, czyli tak zwanym Crawl budget. Tekst jest dedykowany właścicielom dużych serwisów internetowych lub stron często aktualizowanych.

W związku z tym, poza przytoczeniem założeń zawartych w przewodniku, dopisałem podstawowe kwestie odnośnie Crawl budget. Zarówno przewodnik, jak i generalnie kwestie odnośnie limitów indeksowania stron przez roboty Google dotyczą głównie domen z dużą ilością unikalnych stron, które są aktualizowane stosunkowo często. Przewodnik określa stosunkowo w taki sposób:

- ponad milion unikalnych stron z treścią aktualizowaną raz w tygodniu

- ponad 10 tys. Unikalnych stron z treścią aktualizowane codzienne

Powyższe ramy są założone w przybliżeniu.

Co to jest crawl budget? W tym crawl capacity limit i crawl demand

Aby strona znalazła się w wynikach wyszukiwania, musi być zaindeksowana przez daną wyszukiwarkę. To zadanie botów indeksujących, tzw. crawlerów które regularnie przeszukują sieć w celu znalezienia nowych lub zaktualizowanych treści. Przez „indeksowanie” mam na myśli nie tylko docieranie do nowopowstałych stron, ale również ponowne wizyty, aby zaktualizować bazę danych.

„Roboty analizują strony internetowe i otwierają zawarte w nich linki, podobnie jak użytkownicy przeglądający treści w internecie. Przechodzą od linku do linku i przesyłają dane o stronach internetowych na serwery Google.”

Więcej o tym jak działa wyszukiwarka na Googleblogu

Sposób poruszania się „crawlerów”, czyli przez linki po sieci, budzi skojarzenia z pająkami, stąd też tak są określane oraz wizualizowane. Tak samo jak Google inne wyszukiwarki takie jak Bing, Baidu czy Yandex również delegują swojego bota indeksującego. Lista wyszukiwarek i ich "crawlerów" poniżej:

- Googlebot (Google)

- Bingbot (Bing)

- Baiduspider (Baidu)

- YandexBot (YandexBot)

- DuckDuckBot (DuckDuckGo)

- Slurp Bot (Yahoo)

Co to jest Crawl Budget?

Crawl Budget, czyli budżet indeksowania, to w uproszczeniu zasoby, które Google może skierować na indeksowanie danej strony (crawl limit) na tyle, ile jest to potrzebne w ich mniemaniu (crawl demand). Na to wszystko przeznacza określony z góry czas.

Crawl limit, czyli limit wydajności indeksowania odnosi się przede wszystkim do ograniczeń technicznych serwerów, zarówno po stronie Google jak i właścicieli stron.

Internet jest przeogromny, a googlebot nie jest wszechmocny, dlatego Google dedykuje "crawlowaniu" określone zasoby ze względów logistycznych (i zapewne ekonomicznych), a które może zmienić w dowolnym momencie (np. w wypadku awarii).

Druga strona medalu to kwestia wydajności serwera na którym trzymasz witrynę. Googlebot zdąży wykonać więcej pracy na szybko wczytującej się stronie, to logiczne. Wtedy tez zwiększa się limit, a gdy serwer jest awaryjny i wolny, limit się zmniejsza.

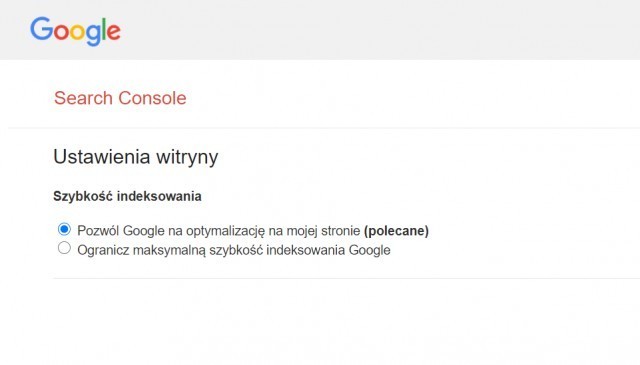

Ponadto boty indeksujące w zamyśle nie powinny doprowadzić do przeciążenia łączy serwera, wiec już na tych mniej wydajnych, np. na współdzielonych hostingach (shared hosting) limit jest niższy. Jeśli dochodzi do przeciążenia serwera i wiesz, że powodem jest googlebot, możesz samodzielnie ustawić limit w Google Search Console.

Crawl demand, czyli zapotrzebowanie na indeksowanie, to próba odpowiedzi na pytanie „Jak wystarczająco często googlebot powinien odwiedzić adres url?”. Ma to sens, ze popularniejsze (mające więcej backlinków) „crawluje” zdecydowanie częściej niż te rzadko aktualizowane, a powielone i nieistotne strony postrzega jako strata czasu

Dobre praktyki optymalizacji crawl budget, oficjalne wytyczne

Przewodnik dostarcza także cenne wskazówki jak zoptymalizować budżet indeksowania, mianowicie:

- Stosuj tag kanoniczny (rel=canonical) dla zduplikowanych treści

- Blokuj indeksowanie nieistotnych stron, dużych elementów spowalniających ładowanie strony,

- Tzw. nieskończone przestrzenie (np. kalendarz) oraz inne niepotrzebne komponenty w pliku robots.txt

- Usunięte strony powinny odpowiadać kodem serwera 404 (nie znaleziono strony) lub 410 (strona usunięta)

- Usuń pozorne błędy 404 (czyli sytuacje w których serwer wysyła kod odpowiedzi 200 odpowiedni dla prawidłowych stron, zamiast kodu 404 lub 410)

- Używaj prostego tagu więcej o tym jakie linki są wskazane w odniesienu do crawlowania

- Odświeżaj mapę witryny (Sitemap) z użyciem tagu lastmod (aby wskazać datę ostatniej aktualizacji danej strony)

- Nie stosuj długich łańcuchów przekierowań 301 (czyli gdy po wpisaniu adresu url, następuje przeniesienie do innej strony), optymalnie nie więcej niż 3, maksymalnie 5

- Przyspiesz wczytywanie strony

- Sprawdzaj stan indeksowania w sekcji statystyki indeksowania w Google Search Console

Fakty i mity dotyczące Crawl budget

W ostatniej części przewodnika rozliczono się z powszechnymi opiniami odnośnie budżetu indeksowania.

Nieprawdziwe jest, że:

- Skompresowane mapy witryny zwiększą limit indeksowania

- Częściej aktualizowane strony lub przeciwnie, stare treści są lepiej oceniane przez Google

- Parametry i generalnie skomplikowane adresy URL mogą stanowić problem

- Mniejsze strony są rzadziej „crawlowane” bez względu na częstotliwość aktualizacji treści

- Kwestie indeksowania stanowią czynnik rankingowy

- Polecenie opóźnienia indeksowania (crawl delay) w robots.txt jest przetwarzane przez googlebota

Natomiast prawdziwe jest to, że:

- Strony bliżej strony głównej są częściej indeksowane

- Im szybciej wczytuje się strona, tym większy crawl limit oraz im więcej błędów serwera, tym mniejszy crawl limit

- Alternatywne adresy URL (np. z parametrem hreflang) są uwzględnione w crawl budget

- Użycie tag nofollow w linku sprawi, że boty indeksujące nie trafią do danej podstrony, aczkolwiek nie oznacza to, że nie dotrze do niej z innego linku niezawierającego dyrektywy nofollow

Więcej o Crawl budget

Przeczytaj cały oficjalny przewodnik po zarządzaniu budżetem indeksowania przeznaczony dla właścicieli dużych witryn na stronie Google Search Central oraz więcej informacji o tym, czym jest dla Googlebota, aby dowiedzieć się więcej w tym temacie.

Paweł Białas

Paweł Białas