Co, jak i kiedy optymalizować?

Artykuły9 sierpnia 2018Autor:Michał Suski

Po przeczytaniu tego artykułu dowiesz się które elementy warto zoptymalizować, jak wykonać skuteczną optymalizację treści i w jakiej kolejności się za to zabrać. Optymalizacja stron internetowych kojarzona jest zazwyczaj z poprawą szybkości działania i nasyceniem słowami kluczowymi. Taka definicja jest jednak mało konkretna, w tym artykule postaram się rozwinąć najbardziej istotne elementy, które warto poprawić.

Czas ładowania

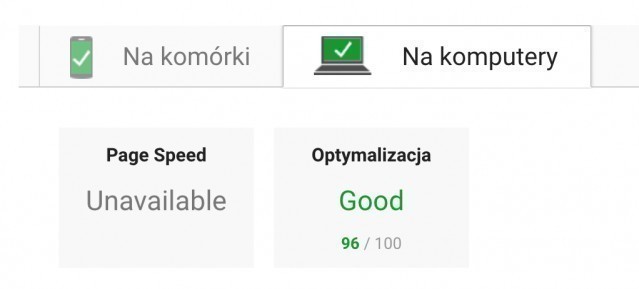

Google Pagespeed Insights, a optymalizacja obrazów

Większość z was zapewne ufa wskazaniom z Pagespeed, ale czy zdajecie sobie sprawę że można wyciągnąć więcej? Kluczowy w tym przypadku jest rozmiar obrazków na stronie. Pagespeed sprawdza ich kompresję, jednak nie bierze pod uwagę rozmiaru wszędzie tam, gdzie obraz jest generowany - przykładem może tu być popularna wtyczka do wordpressa - Revolution Slider. To kluczowe w przypadku korzystania z plików, które można pobrać po analizie. Obrazy zoptymalizowane przez Google pozostaną w tej samej rozdzielczości, co oznacza, że nie odciążamy strony na tyle na ile to możliwe. Pamiętajcie o kadrowaniu zdjęć, dzięki temu jeszcze efektywniej skrócicie czas ładowania strony. Warto sprawdzić każdy typ podstrony w PSI - home, kategorie, produkty, blogposty czy galerię zdjęć.

Ten przykład dedykuję wszystkim klientom, którzy wrzucają zdjęcia w slidery prosto z aparatu.

Optymalizacja zawartości .htaccess

Przekierowanie przekierowania nie przenosi całej mocy domeny - to oczywiste. Nawet John Mueller swego czasu powiedział, że więcej niż trzy przekierowania tracą sens. W tym przypadku chciałbym się jednak skupić na innym aspekcie dużej ilości niepotrzebnych przekierowań. Plik .htaccess jest ładowany za każdym przeładowaniem, dlatego warto zadbać o jego higienę i pozbycie się przekierowań, które nie mają sensu.

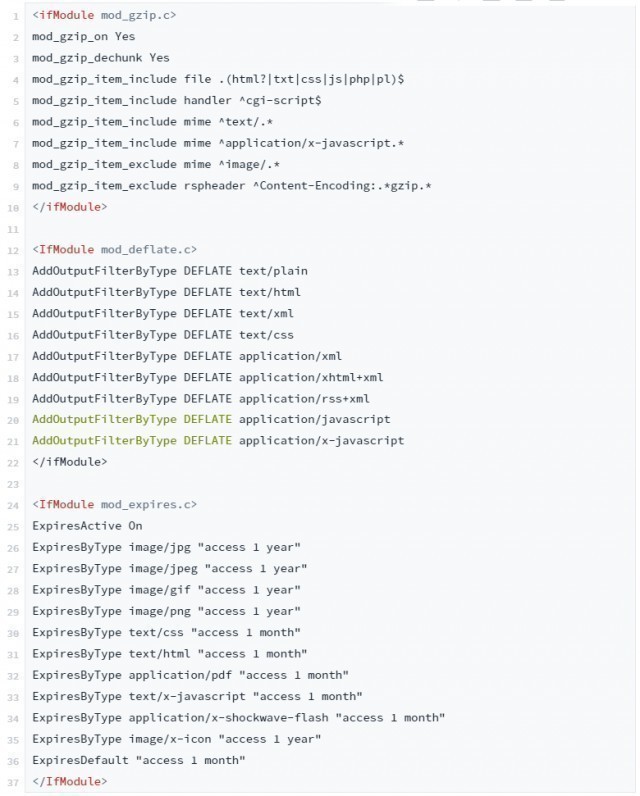

Kompresja i cache w .htaccess

Tutaj kluczowe są pojęcia: cache, kompresja gzip i mod deflate. Przechowywanie jak największej ilości zasobów w cache pozwala skrócić czas ładowania osobom, które już odwiedziły naszą stronę. Da to pewną przewagę nad nieodwiedzaną wcześniej konkurencją. Uruchomienie tych funkcji jest stosunkowo łatwe, wystarczy umieścić na początku pliku .htaccess następującą składnię:

Oczywiście gdy jest jeszcze jakiś inny rodzaj pliku - trzeba dodać go do składni jednak przeważnie to wystarcza. Pamiętajcie o zrobieniu kopii pliku na wypadek gdyby coś poszło nie tak!

AMP - a komu to potrzebne?

Pakiety internetu w telefonie coraz większe, LTE coraz powszechniejsze a Google przykłada coraz większą wagę do szybkości ładowania. AMP to coś więcej niż tylko szybka strona. AMP to przechowywana w cache Google mobilna wersja witryny, która nie ładuje się, ona się po prostu pojawia po kliknięciu. Co z tego mamy? Przede wszystkim zadowolonych użytkowników, którzy w mgnieniu oka dostają to, czego szukali (o ile to mamy) i lepsze CTRy. W jaki sposób ją wdrożyć i z jakimi ograniczeniami się to wiąże przeczytasz poniżej.

W jaki sposób wdrożyć AMP

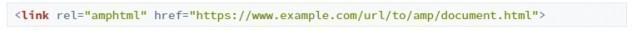

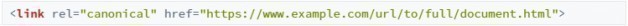

Jeśli mamy do czynienia ze stroną opartą o WordPress, sprawa będzie stosunkowo łatwa. Wystarczy wybrać szablon przystosowany do AMP, skopiować zawartość 1:1 w porównaniu do wersji desktopowej i dodać dwa tagi.

Do wersji desktopowej:

Do wersji AMP:

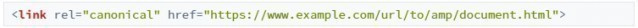

Nie trzeba być fanatykiem technologii, aby zbudować kompletną stronę w technologii AMP. Witryny, które w desktopowej wersji spełniają wymagania accelerated mobile pages są po prostu bardzo szybkie, w takim przypadku stosujemy tylko:

Strona w całości wykonana zgodnie z AMP

Ciemną stroną AMP jest jeszcze większa zależność od Google i ograniczone możliwości. Budując witrynę w tej technologii jesteśmy zmuszeni do korzystania z bibliotek JS Google, które nie obejmują wszystkich funkcji (swoją drogą często niepotrzebnych animacji czy efektów specjalnych). Po wejściu w życie Speed Update warto rozważyć dołożenie wersji AMP do strony lub jeśli w planach jest nowa strona - postawienie całej witryny w zgodzie z AMP. Warto pamiętać, że Google (oficjalnie lub nieoficjalnie) faworyzuje swoje technologie.

TTFB

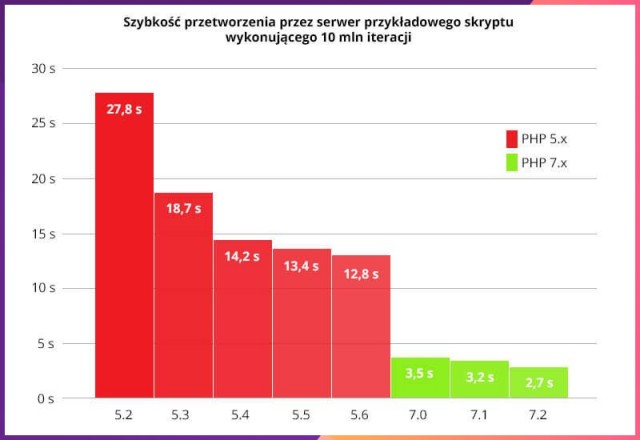

TTFB to czas, który upływa od przesłania zapytania do pierwszych danych przesłanych przez serwer. Nie jest regułą zależność TTFB i pozycji, szeregująca strony w SERP od tych z najdłuższym TTFB z tyłu do tych w top10 z najkrótszymi czasami, jednak bardzo często da się ją zauważyć. Skrócenie TTFB nigdy nie zaszkodzi dlatego warto spróbować poprawić swój wynik.

Jak skrócić time to first byte w 30 sekund

Sprawdź wersję PHP na serwerze, jeśli to 5.x to jesteś w domu. W porównaniu z wersjami 7.x czasy są nieporównywalnie dłuższe. Zmień wersję, sprawdź czy strona się nie wysypała i ciesz się TTFB na znacznie lepszym poziomie. Wartości rzędu 600 - 800ms są do zaakceptowania, jeśli mimo wszystko TTFB jest dłuższy - rozważ zmianę serwera. Dla potwierdzenia tej tezy wykonaliśmy kilka testów obrazujących różnicę w wydajności serwerów z różnymi wersjami PHP.

Struktura strony a crawl budget

Optymalizacja crawl budget zyskała na wadze w ostatnim czasie. Jeszcze bardziej trzeba zwracać uwagę na podstrony kwalifikowane jako thin lub duplicate content. Tego typu podstrony nic nie wnoszą do zawartości, często są sztucznymi tworami silników, które odpowiadają za wygenerowanie kodu HTML witryny. Oczywistym jest, że strona bez CMS na czystym html nie będzie płatała figli, problemy zaczynają się w momencie gdy korzystamy z różnych systemów.

Warto sprawdzać strukturę strony regularnie raz np. raz na miesiąc i po wszelakich aktualizacjach. W tym celu można wspomagać się narzędziami takimi jak Screaming Frog czy Deep Crawl. Pozbycie się niechcianych podstron, które marnują cenny crawl budget powinno odbyć się w następującej kolejności:

- usunięcie źródła problemu np. klikalne tagi, indeksowane widoki produktów lub błąd we wtyczce po aktualizacji (ostatnia głośna wpadka Yoast SEO, gdzie po aktualizacji zmieniły się ustawienia przekierowania podstron odnośników bezpośrednio do plików),

- przekierowanie 301 podstron na odpowiadające im zawartością lub jeśli takich nie ma - przekierowanie na 404 połączone z wstawieniem tagu noindex,

- ręczne usunięcie linków z indeksu w Google Search Console.

Optymalizacja treści

Jak często optymalizować treści na stronie?

Zagadnienie jest bardzo złożone. Wpływają na nie przede wszystkim intensywność działań konkurencji jak i dynamika konkretnej niszy. Z perspektywy specjalisty każde działanie dla klienta powinno być uzasadnione ekonomicznie - praca włożona w poprawę struktury, korekty treści czy rozbudowanie profilu linków powinno wykazywać najlepszy stosunek kosztów do efektu w danym momencie.

Łatwo wyobrazić sobie standardową ścieżkę jaką przechodzi projekt - od optymalizacji technicznej, przez korekty treści po pozyskanie linków. Prędzej czy później pojawia się jednak wątpliwość czy nie byłoby korzystniej wrócić do optymalizacji niż pozyskiwać kolejne linki.

Audyt treści w oparciu o konkurencję

Skrupulatne podejście do analizy konkurencji odpłaca się dobrymi wynikami, jednak jej czasochłonność nie pozwala na zbyt częste powtarzanie tej procedury. Zebranie danych o konkurencji i ich analiza to często kilka godzin na jedną podstronę. W takiej sytuacji podejmujemy decyzję w oparciu o pobieżną analizę, wyczucie lub stosowany schemat działania. Takie podejście jest nieoptymalne, możemy przeznaczyć czas na wykonanie zadań, które aktualnie nie będą priorytetowe. Ryzyko popełnienia błędu wzrasta, a ciągle zmieniający się algorytm powoduje, że wypracowane schematy są często nieaktualne.

Sprawdź czy strona wymaga korekt w mniej niż 5 minut

Od dłuższego czasu pracowaliśmy w KampanieSEO nad rozwiązaniem tego problemu. Zaowocowało to stworzeniem narzędzia, które automatyzuje proces pozyskania danych o konkurencji i pozwala szybko analizować konkurencję. Standardowy proces, który prowadzi do podjęcia decyzji o wykonaniu optymalizacji wygląda u mnie następująco:

- Analizuję pozycje poszczególnych słów kluczowych dla podstrony.

- Typuję frazy, które stagnują lub zanotowały spadki od poprzedniej optymalizacji.

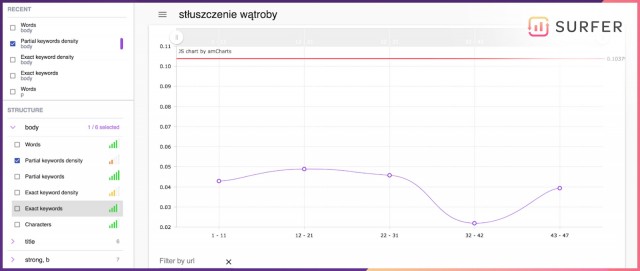

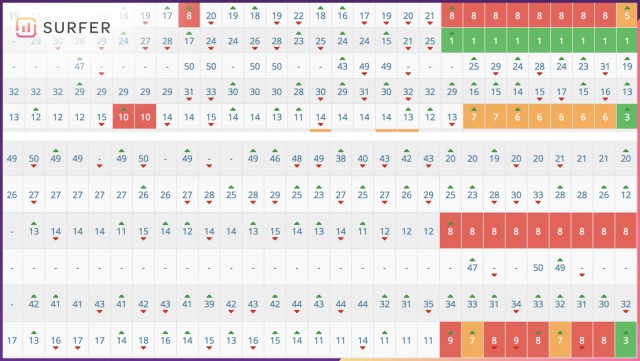

- Odpalam Surfera (https://surferseo.com/) i wpisuję wybraną frazę.

- Po minucie mam przed oczami interfejs, który już po kilku kliknięciach pomaga mi podjąć decyzję o konieczności przeprowadzenia optymalizacji.

Podstawowe metryki

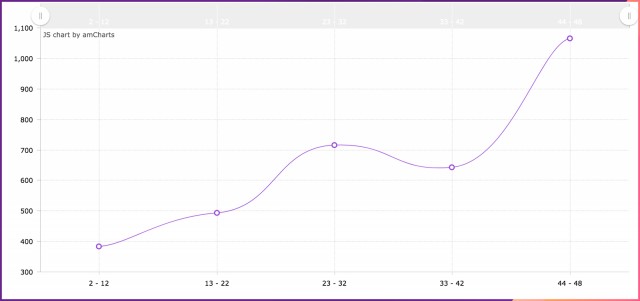

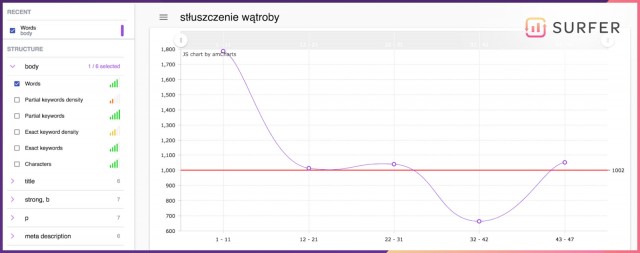

Długość treści i jej nasycenie słowami kluczowymi to podstawowe elementy, które można przeanalizować bardzo szybko. Nie dadzą pełnego obrazu sytuacji, ale spokojnie wystarczą do stwierdzenia, czy mamy problem. Na poniższych wykresach widać, jak bardzo strona klienta odbiega od konkurencji pod względem zagęszczenia słowami kluczowymi oraz ilości treści.

Redukcja zagęszczenia vs. dopisanie treści

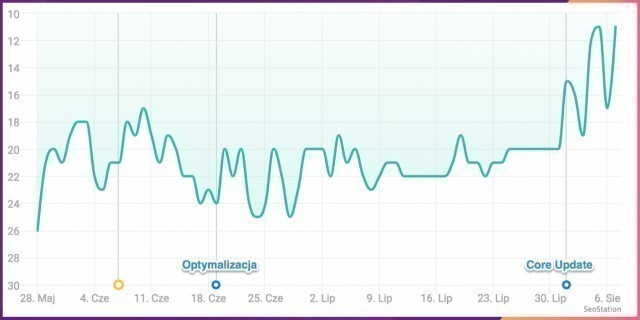

Podjęcie tej decyzji jest trudne. Z jednej strony mamy szybką akcję, polegającą na redukcji zagęszczenia słów kluczowych - zadanie na 20 minut wraz z wdrożeniem. Z drugiej strony mamy dopisanie około 800 słów, co przy medycznej niszy wymaga nie lada umiejętności i wiąże się ze znacznie dłuższym czasem realizacji oraz kosztami - fachowy copywriting, oczekiwanie na akceptację treści itp. Nie warto iść na skróty, dopisanie treści o mniejszym zagęszczeniu daje znacznie lepsze wyniki niż sama redukcja słów kluczowych. Dlaczego? Przykład poniżej - sama redukcja nie dała oczekiwanych wyników, dlaczego rozpocząłem proces pozyskania dodatkowej treści. Tak się złożyło, że po sierpniowym update strona poszła mocno do góry zanim uzyskałem dodatkowe treści.

Redukcja density nie dała zamierzonych efektów, pozycja przestała spadać, ale nie podniosła się jak w przypadku działań obejmujących dopisanie treści.

Decyzja zapadła - jak przekonać klienta?

O ile na samo pisanie tekstu nie mamy większego wpływu, o tyle Surfer jest w stanie przekonać klienta do zmian - przesyłanie wykresów obrazujących braki wraz z prośbą o akceptację zmian zwiększa konwersję na zgodę w bardzo dużym stopniu. Nie liczyłem tego, ale naprawdę jest dużo łatwiej odpowiadać na pytania “A po co te zmiany?”.

Wytyczne zaakceptowane - przechodzimy do optymalizacji

Każdy ma swój sposób na wykonanie optymalizacji, jednak mając pod ręką posegregowane dane o konkurencji, warto skorzystać z pomocy Surfera. Wytypowałem frazę i odpaliłem analizę. Szukam znacznych rozbieżności między moim contentem, a konkurencją z top10. Czynniki, które skłoniły mnie do wykonania optymalizacji takie jak zbyt wysokie zagęszczenie słów kluczowych w body rozkładam na mniejsze elementy.

Analizuję osobno paragrafy, nagłówki i alty, aby mieć pewność, że żaden z elementów jest optymalnie nasycony frazami, a wszystkie razem dają odpowiednie zagęszczenie w body.

Więcej o optymalizacji pisałem ostatnio na blogu Hekko - https://www.hekko.pl/blog/tresci-na-strone-w-modelu-data-driven/

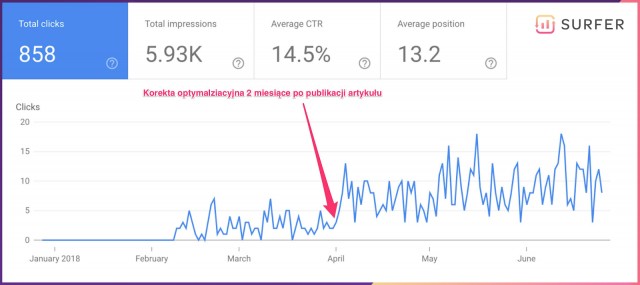

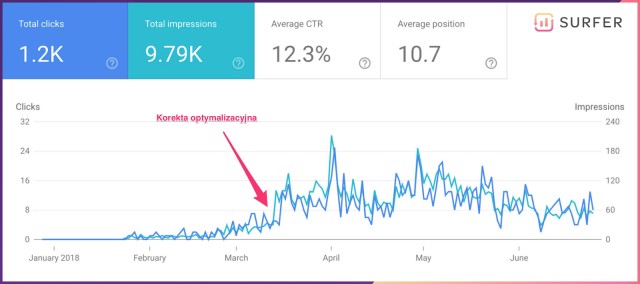

Czego spodziewać się po dobrej optymalizacji

Sumienna analiza i wykonanie zadań w oparciu o twarde dane pochodzące z własnej analizy lub narzędzia to często podwojenie lub potrojenie ruchu na optymalizowanej podstronie. Na zrzutach z ekranu zaznaczyłem moment wdrożenia korekt - jak widać opłaciło się. Przykłady pochodzą z komercyjnych serwisów z branży hotelarskiej i ogrodniczej.

Praca sprowadziła się do podciągnięcia długości tekstu i korekt zagęszczenia słów kluczowych w poszczególnych tagach - paragrafach, nagłówkach i altach. Dzięki danym zadanie zostało wykonane szybko i precyzyjnie, co jak widać zrewanżowało się solidnym wynikiem.

Blogposty w branży hotelarskiej

Podstrony ofertowe w branży ogrodniczej

Podsumowanie

Nie ma jednoznacznej odpowiedzi na pytanie jak często i co optymalizować, ale mam jedną radę - porównujcie swoją stronę z konkurencją jak najczęściej. Pozwoli to uniknąć niepotrzebnych kosztów w przyszłości. Częste monitorowanie stanu swojej witryny pozwala na szybką odpowiedź na działania konkurencji. Kolejność działań jest zbieżna z kolejnością przedstawienia zagadnień w artykule.

- Zacznij od elementów technicznych i popraw czas ładowania strony. Zadbaj o przejrzystą strukturę podstron oraz czas ładowania, który jest jeszcze ważniejszy po Speed Update.

- Monitoruj swoje treści i śledź ruchy konkurencji. W ten sposób będziesz na bieżąco z trendami, które sprawdzają się w Twojej niszy.

Pamiętaj, że optymalizacja to proces ciągły, tym bardziej intensywny, im częściej konkurencja wykonuje ruchy przynoszące jej korzyści.

Przygotowując plan działania na kolejny okres - tydzień, miesiąc lub kwartał - warto poświęcić kilka minut na sprawdzenie, czy promowana witryna nie odbiega od konkurencji zarówno technicznie jak i semantycznie. Te kilka minut będzie uzasadnione ekonomicznie jeśli w choćby 1 przypadku na 10 znajdziemy problem, który pozwoli odblokować stronę i tym samym sprawi, że nie poniesiemy niepotrzebnych kosztów związanych z linkbuildingiem.

Michał Suski

Michał Suski